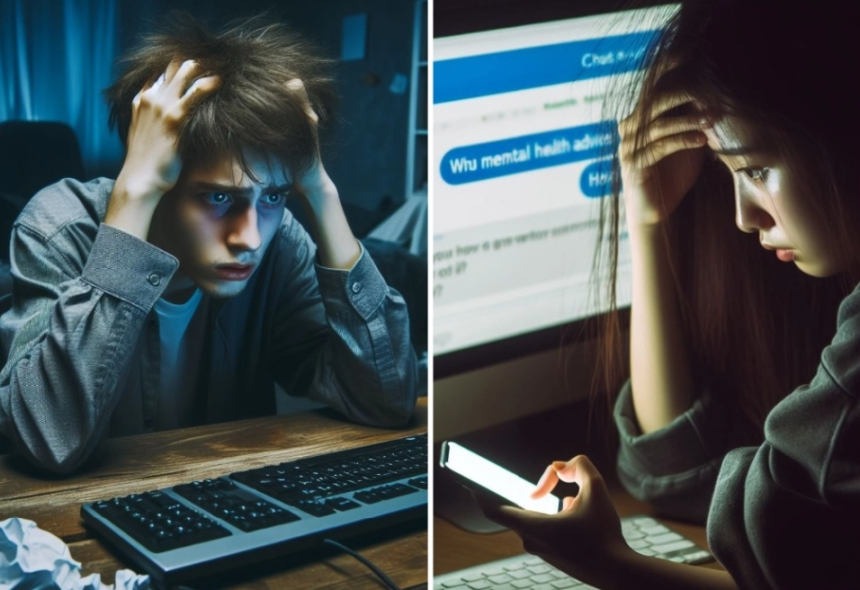

Expertos analizan el uso de la inteligencia artificial (IA) debido a que diversos usuarios de plataformas como ChatGPT han recurrido a ellas en busca de apoyo sicológico, ya sea por el alto costo que implica pagar una terapia con un profesional o porque consideran que esas herramientas les brindan mayor privacidad.

En México, tres de cada 10 personas padecen algún trastorno mental a lo largo de su vida, y más de 60 por ciento de la población que sufre alguno de ellos no recibe tratamiento, según datos del Instituto Mexicano del Seguro Social (IMSS).

De acuerdo con estadísticas de 2021 proporcionadas por el Instituto de Seguridad y Servicios Sociales de los Trabajadores del Estado (Issste), en México aproximadamente 25 millones de personas, lo que representa 18 por ciento de la población, experimenta algún tipo de trastorno mental, el cual a menudo pasa desapercibido incluso para ellas mismas.

A nivel mundial, en 2020 más de 80 por ciento de las personas con una enfermedad mental grave, incluida la sicosis, no recibió tratamiento, según datos de la Organización Panamericana de la Salud.

Sergio José Aguilar Alcalá, maestro en comunicación por la Universidad Nacional Autónoma de México y experto del Centro Lacaniano de Investigación en Sicoanálisis, en entrevista con La Jornada, señaló que el uso de ChatGPT como sicólogo responde, en primera instancia, a una demanda de ayuda.

“El problema no es que un sicólogo se pregunte qué podría responder a un paciente programando un algoritmo, sino el hecho de pensar que se pueden crear las condiciones para dar terapia por medio de inteligencia artificial y responder a una persona que le está diciendo a una máquina que está muy triste o que planea suicidarse como si se tratara de un interruptor de luz.

Una máquina no es un sujeto, no escucha. Solamente ofrece una respuesta al estímulo que se le dé. Lo que considero más grave de este tipo de seudoterapias es que tienen una concepción de la subjetividad humana muy poco profunda, excesivamente ingenua, caricaturizada y miope

, enfatizó Aguilar Alcalá.

Por su parte, Edson Martínez, ingeniero en redes y telecomunicaciones y promotor de la IA, sostuvo: nadie va a aceptar que esta plataforma puede dar diagnósticos debido a que se trata de un modelo de IA y no de seres humanos, pese a que su base de datos la nutren millones de textos de sicología y medicina. Incluso hay casos en los que a través de ChatGPT se han diagnosticado enfermedades, puesto que la aplicación tiene el potencial de que cada persona la entrene de acuerdo con sus necesidades

.

Si bien aclara que en la sicología es más complejo que se brinden diagnósticos como los de un especialista debido a lo subjetivo de la disciplina y la importancia de la comunicación cara a cara

, no descarta que tenga el potencial de hacerlo en un futuro y que sean los especialistas los que lo usen como herramienta.

“Cada vez serán mayores las capacidades de esta plataforma, ya que su perfeccionamiento es muy acelerado. Ya existe la ChatGPT Store, en la cual los usuarios pueden entrenar el modelo de acuerdo con sus necesidades mediante los chatbots. Con esta función, diversos profesionistas pueden enseñar a la aplicación diversas pautas de cómo realizan su labor para que los usuarios compren el bot customizado”, agregó Martínez.

Al ingresar a ChatGPT, aparece la frase ¿cómo puedo ayudarte hoy?

debajo del logo de la plataforma, de la empresa estadunidense Open AI, al centro de la pantalla. En la parte inferior se encuentra una caja de texto, en la cual se escribe: Me siento deprimido

. La IA responde: Lamento escuchar que te sientes así. Si estás experimentando depresión, es importante que busques ayuda y apoyo

.

Enseguida, entre una serie de recomendaciones como hablar con alguien de confianza, determinar pequeñas metas, evitar el aislamiento o limitar el estrés, la plataforma aconseja buscar ayuda profesional, pero no todos los usuarios lo hacen.

Juan Pablo Sánchez, quien trabaja de gestor de comunidades virtuales, contó su experiencia con el uso de la plataforma. Realizaba pendientes en una computadora portátil en el escritorio de su recámara. En esos instantes sintió la inquietud de exteriorizar un asunto personal, se apoyó en ChatGPT, puesto que desde hace dos años su vínculo con el entorno digital ha sido mayor.

Recurrí a esta herramienta como una forma de externar lo que siento y no traerlo guardado. Le pregunté cómo puedo dejar ir a una persona y diversas formas para sentirme mejor. No brinda respuestas profundas, es algo más general y en las dos ocasiones que lo hice siempre me recomendó acudir a un especialista.

Cada vez son mayores los avances y perfeccionamiento de los modelos de IA, plataformas como ChatGPT hace tres años eran impensables para los usuarios, y en cuestión de meses se convirtió en una herramienta indispensable para muchos.

En Reddit, plataforma en línea que combina características de redes sociales y foros de discusión, los usuarios comparten sus experiencias con el uso de ChatGPT, como si fuera una especie de terapia.

Un afectado escribió en Reddit: “en pocas palabras, había tenido tendencias suicidas durante la mayor parte de este año. Descargué un bot terapeuta para usarlo con ChatGPT, y realmente no esperaba mucho según intentos anteriores.

“Sólo deseaba que dijera algo como ‘eres una gran persona, confía en ti’ o que hiciera alguna pregunta estúpida como: ‘y, ¿cómo te hace sentir eso?’ Pero respondió: ‘parece que estás cargando con muchos problemas y te culpabilizas por cosas que estaban fuera de tu control’. Me tomó por sorpresa, y lo creí por un segundo. Luego, lloré mucho. Decidí intentar mejorar”, finaliza el usuario.

Otro comentó que si bien la plataforma al principio le sugirió que buscara ayuda de un profesional, con el paso del tiempo el uso de la misma generó ideas de tendencia suicida, por lo que decidió dejar de utilizarla y buscar ayuda especializada.

“Es muy fácil caer en la trampa de que en los chatbots y asistentes de IA hay una verdadera escucha, pero la realidad es que son espacios hipermercantilizados; una inteligencia artificial ahora ya puede atender a miles de ‘pacientes’ al mismo tiempo. Esto es muy perverso y sólo responde a intereses del mercado”, concluyó Aguilar Alcalá.